Beberapa indikator data yang berkualitas antara lain sebagai berikut:

- ACCURACY = data yang tersimpan nilainya benar (name cocok dengan alamatnya)

- DOMAIN INTEGRITY = nilai attributnya sesuai batasan yang diperkenankan (nilai attribut laki n perempuan)

- DATA TYPE = Nilai data disimpan dalam tipe data yang sesuai (data nama disimpan dengan tipe text)

- CONSISTENCY = nilai sebuah field data akan sama semua dalam berbagai berkas (field produk A dgn kode 123, akan selalu sama kodenya di setiap berkas lain)

- REDUDANCY = tidak boleh ada data yang sama disimpan di tempat yang berbeda dalam satu sistem

- COMPLETENESS = Tidak ada nilai atttribut salah yang diberikan dalam sistem

- DATA ANOMALY = sebuah field hanya digunakan sesuai kegunaannya. (field address3 digunakan untuk mencatat baris ketiga dalam alamat bukan untuk telp atau fax)

- CLARITY = Kejelasan arti kegunaan dan cara penulisan sebuah data (penamaan khusus)

- TIMELY = merepresentasikan waktu dari data yang dimasukkan (jika data digunakan perhari maka data pada warehaouse harus juga dibuat per hari)

- USEFULNESS = setiap data harus benar digunakan oleh user

- ADHERENCE TO DATA INTEGRITY RULES = taat pada aturan keterhubungan data

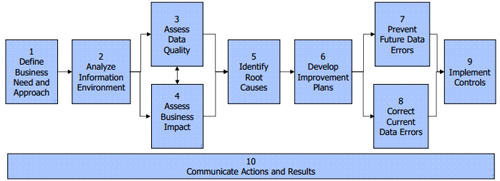

Ada beberapa teknik pengukuran apakah data di organisasi/perusahaan kita berkualitas atau tidak, salah satunya dalam buku “Executing Data Quality Projects: Ten Steps to Quality Data and Trusted Information” oleh Danette McGilvray dari MIT dengan 10 langkah seperti pada gambar dibawah ini

Pendekatan dalam Pengelolaan Kualitas Data

- Data Quality adalah hal yang sangat kritis karena dapat meningkatkan kepercayaan diri data, memungkinkan pelayanan customer menjadi lebih baik, meningkatkan pengambilan keputusan strategik, dan mengurangi risiko dari keputusan rawan.

- Dimensi Data Quality meliputi accuracy, domain integrity, consistency, completeness, structural definiteness, clarity, dll.

- Data Quality dihasilkan dari berbagai sumber dalam sebuah data warehouse dan berbagai sumber polusi yang mengintensifkan tantangan yang dihadapi ketika mencoba untuk membersihkan data.

- Buruknya kualitas data nama dan alamat memberikan keprihatinan serius kepada organisasi. Daerah ini adalah salah satu tantangan terbesar dari Data Quality.